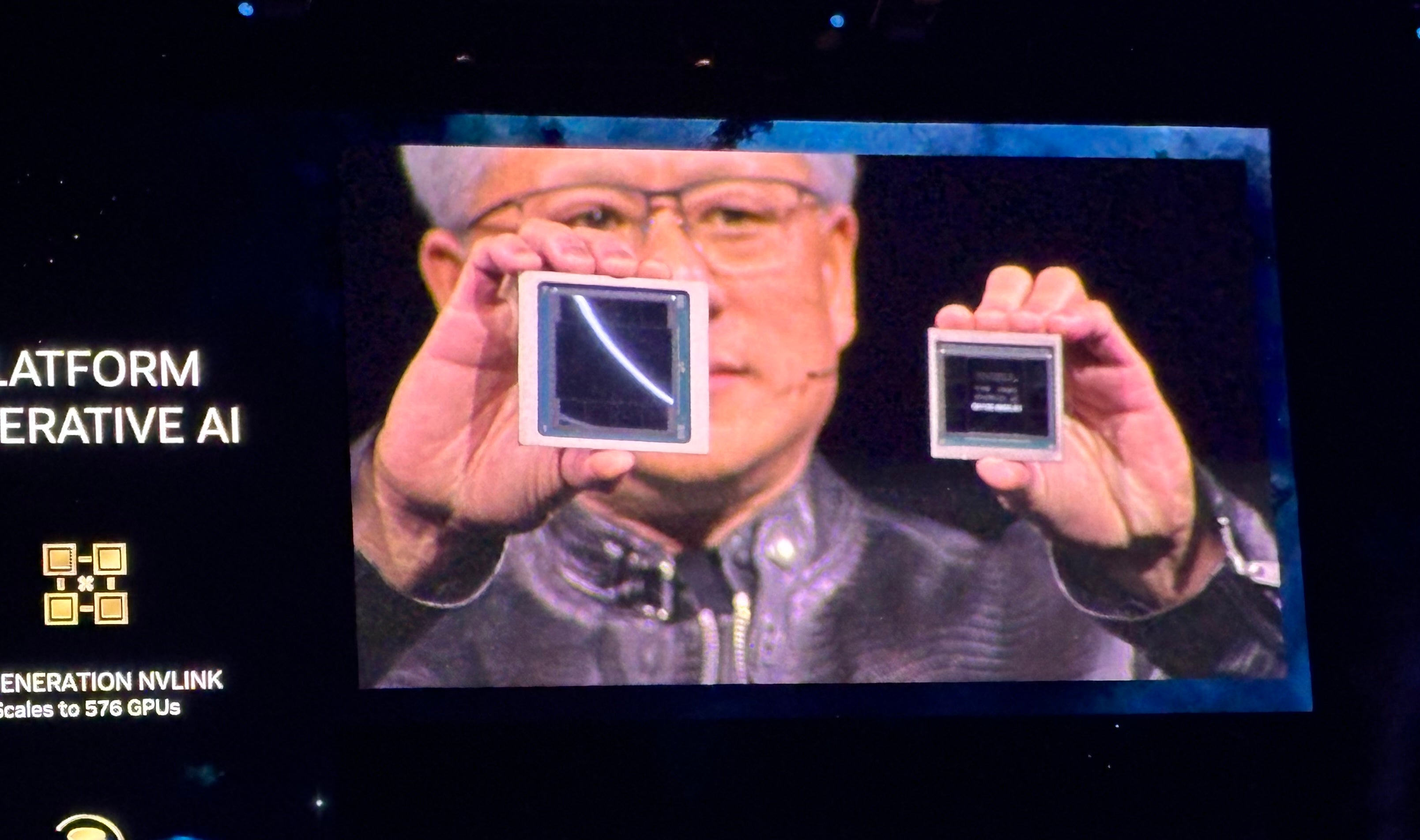

آخرین پلتفرم GPU NVIDIA Blackwell است (شکل Aجنسن هوانگ، مدیر عامل انویدیا در کنفرانس NVIDIA GTC در 18 مارس در سن خوزه کالیفرنیا اعلام کرد که شرکت هایی از جمله AWS، مایکروسافت و گوگل قصد دارند آن را برای هوش مصنوعی مولد و سایر وظایف محاسباتی مدرن اتخاذ کنند.

شکل A

محصولات مبتنی بر Blackwell از شرکای NVIDIA در سراسر جهان در اواخر سال 2024 وارد بازار خواهند شد. هوانگ خط طولانی فناوری ها و خدمات اضافی از NVIDIA و شرکای آن را اعلام کرد و در مورد هوش مصنوعی مولد به عنوان تنها یکی از جنبه های محاسبات شتاب یافته صحبت کرد.

هوانگ با اشاره به CUDA، پلت فرم محاسبات موازی و مدل برنامه نویسی انویدیا گفت: «وقتی شتاب می گیرید، زیرساخت شما پردازنده های گرافیکی CUDA هستند. و هنگامی که این اتفاق می افتد، زیرساخت مشابه برای هوش مصنوعی مولد است.

بلک ول آموزش مدل زبان بزرگ و استنتاج را امکان پذیر می کند

به گفته هوانگ، پلتفرم GPU Blackwell شامل دو قالب است که توسط یک پیوند 10 ترابایت در ثانیه بین تراشه ها به هم متصل شده اند، به این معنی که هر طرف اساساً می تواند به گونه ای عمل کند که گویی “دو قالب فکر می کنند یک تراشه هستند”. دارای 208 میلیارد ترانزیستور است و با استفاده از فرآیند 208 میلیارد 4NP TSMC NVIDIA ساخته شده است. پهنای باند حافظه 8 ترابایت بر ثانیه و عملکرد هوش مصنوعی 20 پنتافلاپس دارد.

به گفته انویدیا، این بدان معناست که بلکول میتواند آموزش و استنتاج بر روی مدلهای هوش مصنوعی با مقیاس تا 10 تریلیون پارامتر انجام دهد.

بلک ول با فناوری های زیر بهبود یافته است:

- نسل دوم TensorRT-LLM و NeMo Megatron، هر دو از NVIDIA.

- قاب هایی برای دو برابر شدن ابعاد محاسباتی و مدل نسبت به موتور ترانسفورماتور نسل اول.

- محاسبات محرمانه با پروتکل های رمزگذاری بومی در رابط حریم خصوصی و امنیت.

- یک موتور فشرده سازی تخصصی برای سرعت بخشیدن به پرسش های پایگاه داده در تجزیه و تحلیل داده ها و علم داده ها.

در مورد امنیت، هوانگ گفت که مکانیسم قابلیت اطمینان «خودآزمایی، یک تست سیستم داخلی، روی هر بیت حافظه تراشه بلکول و تمام حافظههای متصل به آن انجام میدهد. مثل این است که ما تراشه بلکول را با تستر خودش فرستادیم.»

محصولات مبتنی بر Blackwell از ارائه دهندگان خدمات ابری شریک، شرکت های NVIDIA Cloud Partner Program و ابرهای مستقل در دسترس خواهند بود.

خط گرافیکی Blackwell از خط گرافیکی Grace Hopper پیروی می کند که در سال 2022 معرفی شد.شکل B). NVIDIA میگوید بلکول هوش مصنوعی مولد بلادرنگ LLM را با تریلیونها پارامتر با ۲۵ برابر هزینه و مصرف انرژی کمتر خط Hopper اجرا میکند.

شکل B

NVIDIA GB200 Grace Blackwell Superchip چندین پردازنده گرافیکی Blackwell را به هم متصل می کند

همراه با پردازندههای گرافیکی بلکول، این شرکت سوپرتراشه NVIDIA GB200 Grace Blackwell را معرفی کرد که دو پردازنده گرافیکی NVIDIA B200 Tensor Core را با پردازنده NVIDIA Grace جفت میکند – یک پلتفرم ترکیبی جدید برای استنتاج LLM فراهم میکند. سوپرتراشه NVIDIA GB200 Grace Blackwell را میتوان به پلتفرمهای اترنت NVIDIA Quantum-X800 InfiniBand و Spectrum-X800 جدید معرفیشده این شرکت با سرعت حداکثر 800 گیگابایت بر ثانیه متصل کرد.

GB200 در NVIDIA DGX Cloud و از طریق نمونههای AWS، Google Cloud و Oracle Cloud Infrastructure اواخر امسال در دسترس خواهد بود.

طراحی سرور جدید به مدل های هوش مصنوعی با تریلیون ها پارامتر نگاه می کند

GB200 یکی از اجزای GB200 NVL72 است که اخیراً معرفی شده است، یک طراحی رک سرور که 36 CPU Grace و 72 GPU Blackwell را برای 1.8 exaFLOP عملکرد هوش مصنوعی در کنار هم قرار می دهد. NVIDIA موارد استفاده احتمالی را برای LLM های عظیم با تریلیون ها پارامتر از جمله حافظه مکالمه مداوم، برنامه های علمی پیچیده و مدل های چندوجهی پیش بینی می کند.

GB200 NVL72 کانکتورهای نسل پنجم NVLink (5000 کابل NVLink) و GB200 Grace Blackwell Superchip را برای قدرت محاسباتی عظیمی ترکیب می کند که هوانگ آن را “سیستم هوش مصنوعی اگزوفلوپس در یک کابینت واحد” می نامد.

هوانگ گفت: “این بیشتر از میانگین پهنای باند اینترنت است… ما می توانیم هر چیزی را برای هر کسی ارسال کنیم.”

هوانگ گفت: “هدف ما کاهش مداوم هزینه و قدرت – اینها به طور مستقیم با یکدیگر – – کامپیوترها است.”

خنک کردن GB200 NVL72 به دو لیتر آب در ثانیه نیاز دارد.

نسل بعدی NVLink معماری مرکز داده شتاب یافته را به ارمغان می آورد

نسل پنجم NVLink توان ارتباطی GPU دو جهته 1.8 ترابایت بر ثانیه را بین حداکثر 576 GPU ارائه می کند. این تکرار NVLink برای استفاده برای قدرتمندترین LLM های پیچیده موجود امروزی طراحی شده است.

هوانگ گفت: «در آینده، مراکز داده کارخانههای هوش مصنوعی در نظر گرفته میشوند.

معرفی میکروسرویس های استنتاج NVIDIA

یکی دیگر از عناصر احتمالی “کارخانه هوش مصنوعی”، میکروسرویس استنتاج NVIDIA یا NIM است که هوانگ آن را “روشی جدید برای دریافت و بسته بندی نرم افزار” توصیف می کند.

NIMها که انویدیا به صورت داخلی از آنها استفاده می کند، کانتینری هستند که با آنها می توان هوش مصنوعی مولد را آموزش داد و به کار برد. NIM ها به توسعه دهندگان اجازه می دهند از API ها، NVIDIA CUDA و Kubernetes در یک بسته واحد استفاده کنند.

ببینید: پایتون باقی می ماند محبوب ترین زبان برنامه نویسی با توجه به شاخص TIOBE. (TechRepublic)

به گفته هوانگ، به جای نوشتن کد برای برنامهریزی هوش مصنوعی، توسعهدهندگان میتوانند «تیمی از هوش مصنوعی» را تشکیل دهند که روی فرآیند داخل NIM کار میکند.

هوانگ گفت: «ما میخواهیم چترباتهایی بسازیم – خلبانهای هوش مصنوعی – که در کنار طراحان ما کار کنند.

NIM ها از 18 مارس در دسترس هستند. توسعه دهندگان می توانند به صورت رایگان با NIM ها آزمایش کنند و آنها را از طریق اشتراک در NVIDIA AI Enterprise 5.0 اجرا کنند.

سایر اعلامیه های بزرگ NVIDIA در GTC 2024

هوانگ در جریان سخنرانی NVIDIA GTC 2024، طیف گسترده ای از محصولات و خدمات جدید را در زمینه محاسبات سریع و هوش مصنوعی مولد معرفی کرد.

انویدیا cuPQC را معرفی کرد، کتابخانه ای که برای سرعت بخشیدن به رمزنگاری پس کوانتومی استفاده می شود. توسعهدهندگانی که روی رمزنگاری پس کوانتومی کار میکنند، میتوانند برای بهروزرسانی در دسترس بودن با NVIDIA تماس بگیرند.

سوئیچ های شبکه سری X800 NVIDIA زیرساخت های هوش مصنوعی را تسریع می کنند. به طور خاص، سری X800 شامل سوئیچ های اترنت NVIDIA Quantum-X800 InfiniBand یا NVIDIA Spectrum-X800، سوئیچ NVIDIA Quantum Q3400 و NVIDIA ConnectXR-8 SuperNIC است. سوئیچ های X800 در سال 2025 در دسترس خواهند بود.

شراکت های کلیدی که در سخنرانی اصلی NVIDIA شرح داده شد عبارتند از:

- پلتفرم هوش مصنوعی فول استک انویدیا از 18 مارس در هوش مصنوعی Oracle’s Enterprise خواهد بود.

- AWS دسترسی به نمونههای آمازون EC2 مبتنی بر GPU NVIDIA Grace Blackwell و NVIDIA DGX Cloud با امنیت Blackwell را فراهم میکند.

- NVIDIA با استفاده از پلتفرم محاسباتی NVIDIA Grace Blackwell AI و سرویس NVIDIA DGX Cloud که به Google Cloud میآید، Google Cloud را تسریع میکند. گوگل هنوز تاریخ در دسترس بودن را تایید نکرده است، اگرچه احتمالاً اواخر سال 2024 باشد. علاوه بر این، پلتفرم DGX Cloud مبتنی بر NVIDIA H100 معمولاً از 18 مارس در Google Cloud در دسترس است.

- اوراکل از NVIDIA Grace Blackwell در OCI Supercluster، OCI Compute و NVIDIA DGX Cloud روی Oracle Cloud Infrastructure استفاده خواهد کرد. برخی از خدمات ترکیبی هوش مصنوعی Oracle-NVIDIA از 18 مارس در دسترس هستند.

- مایکروسافت از سوپرچیپ انویدیا گریس بلکول برای شتاب Azure استفاده می کند در اواخر سال 2024 در دسترس خواهد بود.

- دل از زیرساختهای هوش مصنوعی و مجموعه نرمافزاری انویدیا برای ایجاد Dell AI Factory استفاده خواهد کرد، یک راهحل AI سازمانی نهایی که از 18 مارس از طریق کانالهای سنتی و Dell APEX در دسترس است. در یک نقطه نامعلوم در آینده، دل از NVIDIA Grace Blackwell Superchip به عنوان پایه ای برای معماری با چگالی بالا و خنک کننده مایع استفاده خواهد کرد. این سوپرچیپ با سرورهای PowerEdge Dell سازگار خواهد بود.

- SAP قابلیتهای تولید را با استخراج پیشرفته NVIDIA در ژول خود اضافه میکند. علاوه بر این، SAP از NVIDIA NIM و سایر خدمات مشترک استفاده خواهد کرد.

هوانگ گفت: «کل صنعت در حال آماده شدن برای بلک ول است.

رقبای تراشه های هوش مصنوعی NVIDIA

NVIDIA در درجه اول با AMD و Intel از نظر ارائه هوش مصنوعی سازمانی رقابت می کند. Qualcomm، SambaNova، Groq و طیف گسترده ای از ارائه دهندگان خدمات ابری از نظر تولید استنتاج و آموزش هوش مصنوعی در یک فضا بازی می کنند.

AWS پلتفرم های استنباط و آموزشی خود را دارد: Inferentia و Trainium. مایکروسافت علاوه بر همکاری با NVIDIA در محصولات متنوع، تراشه هوش مصنوعی خود را برای آموزش و استنتاج دارد: Maia 100 AI Accelerator در Azure.

سلب مسئولیت: NVIDIA هزینه بلیط هواپیما، اقامت و غذای من را برای رویداد NVIDIA GTC که از 18 تا 21 مارس در سن خوزه، کالیفرنیا برگزار شد، پرداخت کرد.